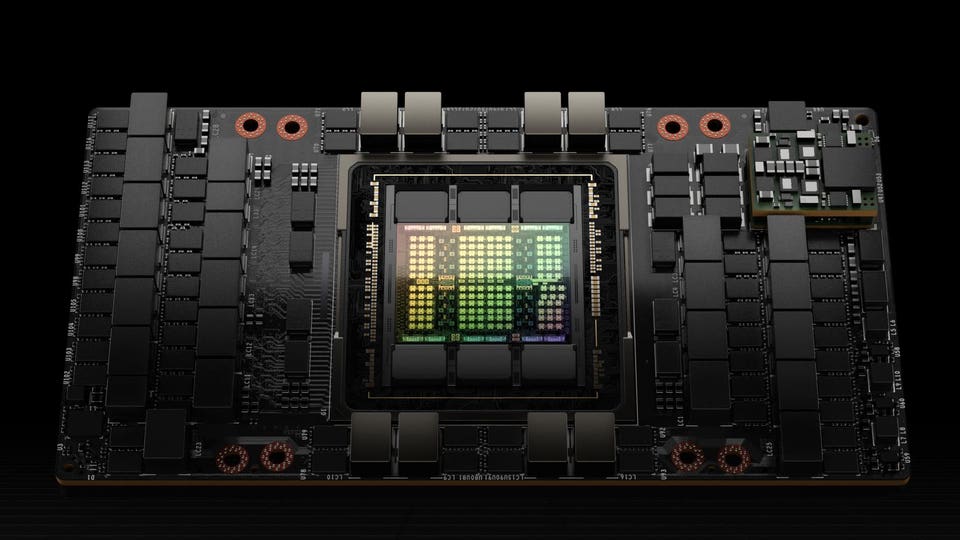

NVIDIA H100 Tensor Core GPU

NVIDIA Corporation

Để biết hệ thống hoạt động như thế nào trên một loạt công việc AI, bạn cần xem số liệu tham khảo MLPerf của nó. AI đang phát triển nhanh chóng, với các công việc AI tạo ra ngày càng được nổi bật hơn, và MLPerf cũng đang theo kịp xu hướng của ngành. Bộ thử nghiệm MLPerf Training v3.0 mới được giới thiệu các bài thử mới cho các bộ phận khuyến nghị và huấn luyện mô hình ngôn ngữ lớn (LLM).

MLPerf Training v3.0

NVIDIA Corporation

MLCommons, quản lý MLPerf, đã công bố kết quả thử nghiệm MLPerf mới nhất hôm nay. NVIDIA H100 chiếm giữ hầu hết mọi danh mục và là duy nhất GPU được sử dụng trong các bài thử LLM mới.

Các số liệu hàng đầu cho các bài thử LLM và NLP BERT thuộc về một hệ thống được phát triển cùng nhau bởi NVIDIA và Inflection AI và được cung cấp bởi CoreWeave, một nhà cung cấp dịch vụ đám mây chuyên về các công việc được tăng cường bằng GPU theo mô hình doanh nghiệp. Để nói rằng các số liệu là ấn tượng là một sự thiếu tự tin.

NVIDIA H100 Chiếm Đoạt Mọi Bài Thử

Bài thử LLM của MLPerf dựa trên GPT-3 LLM được huấn luyện bằng 175 tỷ tham số (GPT-3 là phiên bản GPT mới nhất có sẵn khi bài thử được tạo ra vào năm ngoái). Đây là một công việc tính toán đòi hỏi nhiều, với Lambda Labs ước tính rằng huấn luyện mô hình này yêu cầu khoảng 3.14E23 FLOPS tính toán. Đó là nhiều cơ sở lực đắt đỏ.

NVIDIA đã thiết kế GPU Tensor Core H100 chính xác cho các công việc này, và nó nhanh chóng trở thành một trong những bộ tăng cường phổ biến nhất để huấn luyện các mô hình ngôn ngữ lớn. Đây là vì một lý do tốt. NVIDIA đã giới thiệu một động cơ transformer mới trong H100, được thiết kế rõ ràng để tăng cường huấn luyện và truy vấn mô hình transformer (NVIDIA cung cấp một mô tả tuyệt vời về khả năng đầy đủ của thiết bị trong một bài đăng trên blog). Transformer là trái tim của AI tạo ra, vì vậy dự kiến H100 sẽ hoạt động tốt hơn các phiên bản trước. NVIDIA nói mọi thứ sẽ nhanh hơn trên H100, và động cơ transformer của nó tăng tốc huấn luyện lên đến 6 lần.

Trong 90 hệ thống được bao gồm trong kết quả hôm nay, 82 sử dụng các bộ tăng cường NVIDIA (trong 18 hệ thống không phải NVIDIA được thử nghiệm, tất cả trừ một được gửi bởi Intel). Gần nửa số tất cả các kết quả được dựa trên GPU Tensor Core H100 của NVIDIA. NVIDIA H100 đặt kỷ lục trên mọi công việc được thử trong các bài thử huấn luyện và truy vấn MLPerf, trong khi GPU NVIDIA A100 và NVIDIA L4 cung cấp kết quả truy vấn tốt.

Kết quả MLPerf v3.0 của NVIDIA

NVIDIA Corporation

Nhìn sâu hơn vào các số liệu, GPU Tensor Core H100 của NVIDIA cung cấp thời gian huấn luyện LLM trên mỗi bộ tăng cường là 548 giờ (khoảng 23 ngày). GPU đặt kỷ lục trên mỗi bài th

Trong năm 2020, chuỗi đo lường hiệu năng tính toán học máy MLPerf đã phát hành bản thứ ba của phiên bản mới của nó – MLPerf v3.0. Tuần trước, NVIDIA đã chính thức cập nhật kết quả thử nghiệm mới nhất của mình với MLPerf v3.0 và chứng minh rất rõ rằng chúng thống trị kết quả.

MLPerf là một loạt các bài thử nghiệm tốc độ chung và khoa học ứng dụng học máy. Khi thực hiện các bài thử nghiệm của bản v3.0, NVIDIA đã đo được hiệu năng tuyệt vời của H100, một GPU xác suất thống trị mọi phân khúc AI giao diện điện thoại di động, điều hành lựa chọn thích hợp khác nhau của công ty. H100 đã vượt trội trong các bài thử nghiệm trên những mảng lớn của MLPerf v3.0.

Các thông số hiệu suất cho thấy H100 thống trị quy mô ngày càng lớn hơn. Trong loạt thử nghiệm ResNet-50 v3.0, H100 đã hoàn thành việc để đạt được trải nghiệm trang web cực nhanh nhất trong phân khúc. Đây là hiệu suất cao hơn gấp đôi so với các đối thủ trên thị trường.

Các thành tựu của H100 cho MLPerf v3.0 chứng tỏ rằng thương hiệu giữ vai trò là cận tranh sáng trong phân khúc công nghệ phân tích dữ liệu của họ. Kết quả thử nghiệm của MLPerf v3.0 đã được NVIDIA H100 thống trị, tức là H100 là sự lựa chọn hoàn hảo cho các dự án phân tích dữ liệu với các yêu cầu hiệu suất cao.